1. La fascination pour les événements extrêmes : une erreur analytique

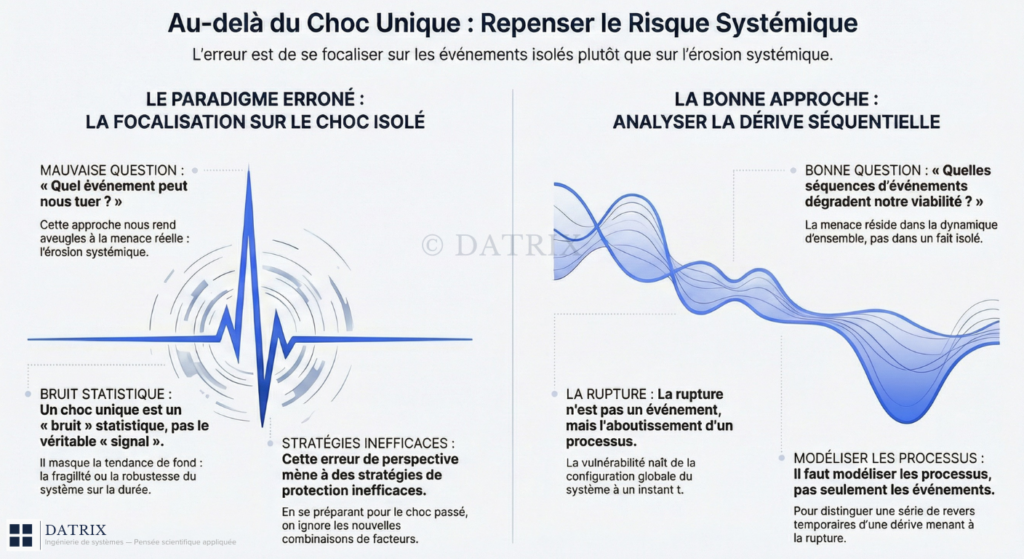

Nous sommes collectivement fascinés par l’événement extrême, le « cygne noir », le choc unique qui semble tout emporter. Une croyance est profondément ancrée dans notre analyse des risques : un seul événement catastrophique peut anéantir un système complexe.

Pourtant, cette focalisation est une faute stratégique. Elle nous condamne à préparer la guerre précédente et nous rend aveugles à la menace véritable : non pas la rupture brutale, mais l’érosion systémique, une dérive lente qui s’opère en deçà de nos seuils de perception.

Pour le comprendre, utilisons une analogie issue de la simulation de systèmes. Une seule exécution d’un modèle stochastique, c’est-à-dire le résultat d’une seule trajectoire simulée (notée H(Xi)), ne donne qu’une information ponctuelle et potentiellement trompeuse sur la performance réelle d’un système, qui est une moyenne sur d’innombrables futurs possibles (une espérance mathématique notée l = E[H(X)]). Le véritable comportement n’émerge que de l’analyse de nombreuses trajectoires. Se fier à une seule trajectoire, c’est piloter une politique industrielle sur la base d’une seule simulation de marché : un acte non pas de prévision, mais de pure superstition.

2. Changer de question : rejeter le choc unique

Nous devons cesser de nous demander « quel événement peut nous tuer ?« . Cette question, mal posée, choisit un objet d’analyse erroné.

Dans l’analyse des systèmes dynamiques, les experts ignorent délibérément la phase initiale de turbulence, la « transience » (K observations), pour se concentrer sur le comportement à long terme, le « régime permanent » (steady-state). Notre biais cognitif nous pousse à l’inverse : nous traitons le régime permanent – le cours normal des choses – comme un acquis stable, et nous érigeons le choc – la phase transitoire – en principal objet d’analyse. C’est une inversion fondamentale : pour le modélisateur, le choc n’est qu’un bruit statistique qui distrait du véritable signal, celui de la fragilité ou de la robustesse du système sur la durée.

Le vocabulaire de « l’accident » ou du « choc » est lui-même trompeur. Le véritable objet d’analyse n’est pas un événement isolé, mais un processus stochastique, qui se définit formellement comme une collection de variables aléatoires indexées par le temps (notée {Xt, t E T}). Par définition, la menace ne réside pas dans un Xt particulier, mais dans la dynamique de la collection {Xt} dans son ensemble.

La bonne question n’est donc pas « Quel choc peut nous détruire ? », mais « Quelles séquences d’événements dégradent notre viabilité ? « .

3. Dérive séquentielle : principe de fragilité structurelle

La viabilité d’un système ne s’évalue pas à sa capacité de résister à un choc unique, mais à sa faculté de contenir des dérives séquentielles. Sa performance doit être comprise comme une trajectoire dans le temps, et non comme un état ponctuel.

Cette idée se retrouve dans plusieurs disciplines de la modélisation :

- Ingénierie de la fiabilité : Dans un modèle de fiabilité (Reliability Model), un système est composé de n composants. Son état opérationnel global (Y) dépend d’une fonction de structure (H) qui prend en compte l’état de tous les composants (X = (X1, …, Xn)). La défaillance n’est pas le fruit d’une seule panne, mais une propriété émergente de l’ensemble. Pour l’illustrer, la défaillance d’un réseau électrique n’est pas la chute d’un pylône. C’est la chute d’un pylône pendant une canicule (qui augmente la demande), alors que deux centrales sont en maintenance (réduisant l’offre), et qu’une attaque cyber vise le centre de contrôle. Aucun composant seul n’est la cause ; la vulnérabilité naît de la configuration du système à un instant t.

- Systèmes dynamiques : Un système de files d’attente (queueing system) ne s’effondre pas à cause d’une seule arrivée massive, mais parce que, sur une période prolongée, le taux d’arrivée dépasse durablement la capacité de service. Ce qui décrit l’évolution vers la rupture, c’est le processus (process {Zn, n = 1, 2, …}), pas un état Zn isolé.

La rupture n’est pas un événement, mais l’aboutissement d’un processus.

4. Erreurs de modélisation et décisions biaisées

Ce mauvais cadrage – la focalisation sur les chocs uniques – conduit à des décisions biaisées et à des stratégies de protection inefficaces, sabotant de l’intérieur les systèmes que l’on cherche à préserver.

Le risque est systématiquement mal évalué car la nature séquentielle des menaces est ignorée. Une pratique courante pour valider un modèle est le « test rétrospectif », qui utilise des données historiques. Or, les théoriciens de la simulation nous avertissent : « à moins que le passé ne soit une réplique représentative de l’avenir, il est préférable de ne pas recourir du tout à ce test ». En se fiant à des séquences passées qui n’ont pas mené à l’effondrement, on s’aveugle sur les nouvelles combinaisons de facteurs qui pourraient y conduire.

Cette mauvaise lecture du temps et du risque n’est pas une simple erreur technique ; elle façonne directement les modèles mentaux défaillants des décideurs. L’erreur la plus dangereuse ne réside donc pas dans l’exécution des opérations, mais dans la conception même des outils de pensée. En ignorant la nature profonde des systèmes qu’ils pilotent, les dirigeants fondent leurs décisions sur des modèles statiques et déterministes. Or, les résultats d’une simulation « ne sont aussi bons que le modèle et les données d’entrée utilisés ». Ainsi, par une ironie tragique, les actions menées pour protéger le système deviennent les instruments inconscients de son sabotage progressif.

5. Zone grise : limites des approches universelles

Cet article ne prétend fournir ni solution miracle ni formule mathématique pour calculer la résilience. Son but est plus modeste mais fondamental : proposer un changement de perspective, en s’appuyant sur des concepts rigoureux issus de la théorie des processus stochastiques et de la simulation Monte Carlo.

Ce choix est délibéré. La nature même des systèmes complexes interdit les solutions universelles. La simulation, l’un des outils les plus puissants pour les étudier, comporte elle-même des limites importantes. Elle « ne donne pas de solutions exactes » et peut « nécessiter d’énormes ressources informatiques« .

Refuser la « fausse clôture » d’une réponse simple et définitive est la première étape, et la plus cruciale, vers une compréhension plus rigoureuse et plus humble des systèmes que nous gérons. L’honnêteté intellectuelle exige de reconnaître que nous naviguons dans une zone grise.

6. Conclusion : focaliser sur les trajectoires, pas les chocs

Nous devons donc abandonner la quête du choc unique pour nous concentrer sur la dynamique des trajectoires. La question qui doit structurer l’action et la stratégie devient alors la suivante :

Face à l’incertitude du temps long, comment distinguer une série de revers temporaires d’une série fatale qui mène silencieusement à la rupture ?

– DATRIX

Répondre à cette question n’est pas une affaire d’intuition ou de prédiction. C’est une affaire de méthode. Cela exige de construire des modèles qui capturent non pas les événements, mais les processus, afin d’analyser les séquences qui dégradent la viabilité, et de mettre en place les garde-fous qui empêchent la dérive de devenir irréversible.

Newsletter – Concepts méthodologiques

Une fois par mois : 1 concept approfondi, 1 cas pratique, 1 check-list à télécharger. Sans bruit. Contenu réservé aux lecteurs sérieux.

Besoin d’aller plus loin ?

J’accompagne individuellement un nombre limité de personnes dans la construction d’un système robuste.